Meta 建了一所學(xué)校,教 AI“情商”

當(dāng)你覺得AI不夠好用時,很可能是因為它還不夠“懂”你。

比如,當(dāng)我們希望ChatGPT能夠產(chǎn)出我們真正想要的東西時,仍然需要學(xué)習(xí)如何使用精確的提示詞去提問,甚至一遍一遍地對它進(jìn)行引導(dǎo)。

這一方面是交流細(xì)節(jié)的問題,另一方面也是因為它很難抓住我們真正的需求和認(rèn)知狀態(tài)。

比如當(dāng)AI去做售貨員,當(dāng)購物的大媽抱怨“這家店太貴”時,一個有“情商”的AI明白顧客可能只是想要折扣,或者需要有人給予她下決心購物的支持;而一個沒情商的AI則會單純地評價產(chǎn)品的價格并回復(fù):“從整個市場的價格參數(shù)看,我們的衣服價格在中位線之上。”

顯然,這樣賣不掉東西。

聽話的關(guān)鍵在聽“音”。AI想要能理解人,就要真正地理解每個人的心理和認(rèn)知狀態(tài)。這就是情商。

我們先做個測試:

在一場聚會上,你看到小明把蘋果從桌子移到了冰箱里,而小紅并不在場。有人問你“小紅會去哪里找蘋果?”

我們大多數(shù)人都能立即回答“桌子上”。這是因為我們知道小紅并不知道蘋果被移動了。

這種理解他人認(rèn)知狀態(tài)的能力,在心理學(xué)中被稱為“心智理論”(Theory of Mind)。

“心智理論”能力就像是給AI裝上了一個“社交理解器”:它能幫助AI理解“話語背后的意思”,而不是簡單地按字面意思回應(yīng)。

讓AI從一個只會背誦標(biāo)準(zhǔn)答案的機器,變成一個真正懂得“察言觀色”的交流伙伴。這樣它才能更好地處理客服、教育、醫(yī)療等需要深入理解人類想法的場景,避免機械化的回應(yīng)帶來的尷尬和誤解。

擁有“心智理論”,可能是讓AI擺脫“知識庫“、成為伙伴或者服務(wù)者的第一步。然而,“情商”這個人類從小就開始發(fā)展的基本能力,最先進(jìn)的AI系統(tǒng)擁有嗎?

01 即使最先進(jìn)的AI,也缺乏情商

12月,Meta的研究團(tuán)隊發(fā)布了一篇名為《Explore Theory-of-Mind: Program-Guided Adversarial Data Generation for Theory of Mind Reasoning》的研究報告。

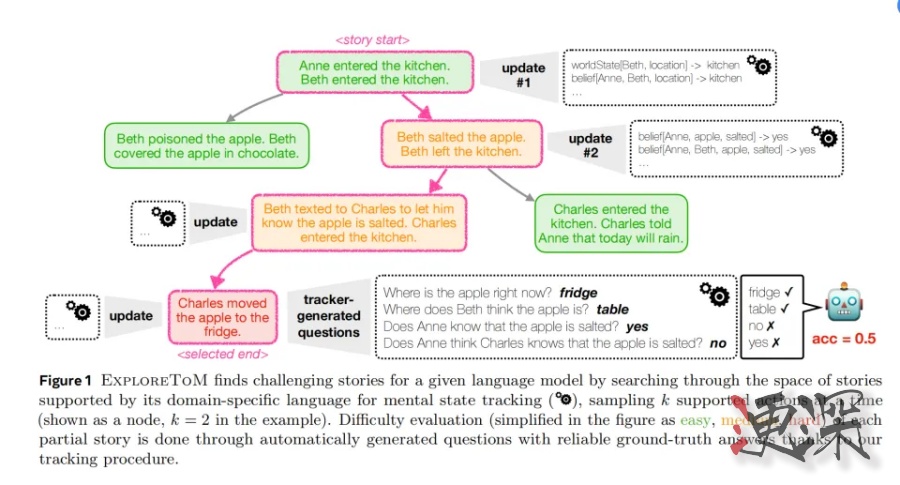

他們開發(fā)了一個叫ExploreToM的系統(tǒng)。它就像一個自動出題機器,利用A*Search算法去生成各種復(fù)雜的社交場景來測試AI的理解能力。

ExploreToM的目標(biāo)是創(chuàng)造那些看似簡單,實則需要深刻理解人類認(rèn)知的場景。這些場景遠(yuǎn)比簡單的“蘋果在哪里”要復(fù)雜得多,并通過不斷累加多個人物、多個房間、私密對話,甚至是秘密觀察,和場景動作使得“故事”逐步復(fù)雜。

研究人員把故事按照其主要考察點分了三組不同復(fù)雜度的情況。

(綠色是簡單的場景,添加橘色條件變難,加紅色條件則最難)

第一層:基礎(chǔ)認(rèn)知追蹤

“瑪麗把鑰匙放在廚房的抽屜里。當(dāng)她出門后,約翰把鑰匙移到了客廳的茶幾上。瑪麗回來后會去哪里找鑰匙?”

這類問題測試AI是否理解:一個人的行為會基于他們所知道的信息,而不是客觀事實。

第二層:信息傳遞理解

這里面相對于只是改變物體,人物間還進(jìn)行了信息傳遞

Beth給蘋果撒了鹽后離開廚房,并發(fā)短信告訴Charles蘋果已經(jīng)撒了鹽。此時Charles進(jìn)入廚房,他知道蘋果被撒了鹽嗎?

這類問題測試AI是否能理解:這其中發(fā)生的信息傳遞

第三層:非對稱認(rèn)知關(guān)系

這個最為復(fù)雜,因為這里面所有角色的認(rèn)知是不對稱的,有的人知道有些事,而別人并不知道。

“珍妮在實驗室配制樣本。湯姆通過監(jiān)控攝像頭看到了整個過程,但珍妮并不知道被觀察。利茲進(jìn)來后把樣本轉(zhuǎn)移到了另一個位置。當(dāng)主管問起這個樣本時,每個人會怎么回應(yīng)?”

這類場景測試AI是否能理解:多人的不同認(rèn)知狀態(tài)、信息獲取的間接性

不僅如此,他們還在這些場景里添加了陷阱作為變量,增加難度。

比如分心陷阱:

“史密斯醫(yī)生在查看病歷時,護(hù)士改變了藥品位置。雖然醫(yī)生在場,但他正在專注地打電話。”這是測試AI是否理解:物理在場不等于注意到變化。

誤導(dǎo)性線索:

“安娜把蛋糕放在紅盒子里。當(dāng)比爾進(jìn)來時,她說:'蛋糕在藍(lán)盒子里'。比爾相信了她的話。”這考察AI是否能區(qū)分:客觀事實、主觀信念、故意誤導(dǎo)。

Meta的研究人員通過ExploreToM創(chuàng)建了超過3,000個獨特的測試場景。每個場景都經(jīng)過至少兩位專家評審,確保其邏輯嚴(yán)密性和測試有效性。

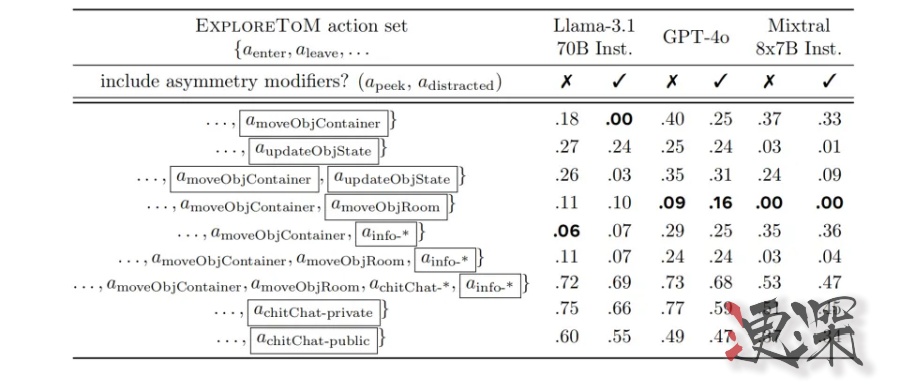

研究團(tuán)隊選擇了目前最具代表性的AI模型進(jìn)行測試,包括OpenAI 的gpt-4o、Meta的Llama-3.1-70B-Inst以及Mixtral-8x7B-Inst。

結(jié)果讓人大跌眼鏡。對于含有某些元素的復(fù)雜問題,GPT-4o只獲得了可憐的9%準(zhǔn)確率,而Llama-3.1-70B準(zhǔn)確率干脆只有0%。

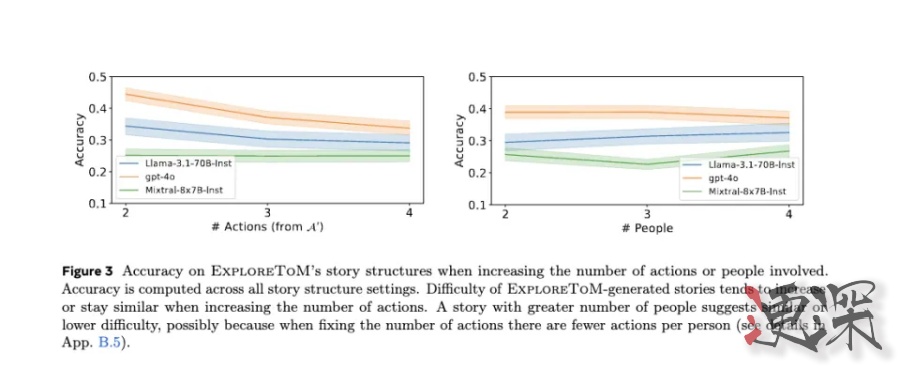

實驗數(shù)據(jù)顯示,當(dāng)故事中的動作數(shù)量從2個增加到4個時,所有測試模型的準(zhǔn)確率都呈現(xiàn)顯著下降趨勢,GPT-4o的準(zhǔn)確率從約0.45降至0.35,Llama-3.1-70B的準(zhǔn)確率從0.35降至0.25,而Mistiral則一直在0.2左右徘徊,動作越復(fù)雜反而越上升,感覺全是靠蒙。

這說明,動作發(fā)生的越多,AI越記不住人物的認(rèn)知狀態(tài)更新。

令人意外的是,增加參與人數(shù)并未導(dǎo)致同樣明顯的性能下降。模型的準(zhǔn)確率僅小幅下降了3-5個百分點。研究人員推測,這可能是因為在固定總動作數(shù)的情況下,增加參與人數(shù)實際上降低了每個人平均參與的動作數(shù)量,從而減輕了狀態(tài)追蹤的整體負(fù)擔(dān)。

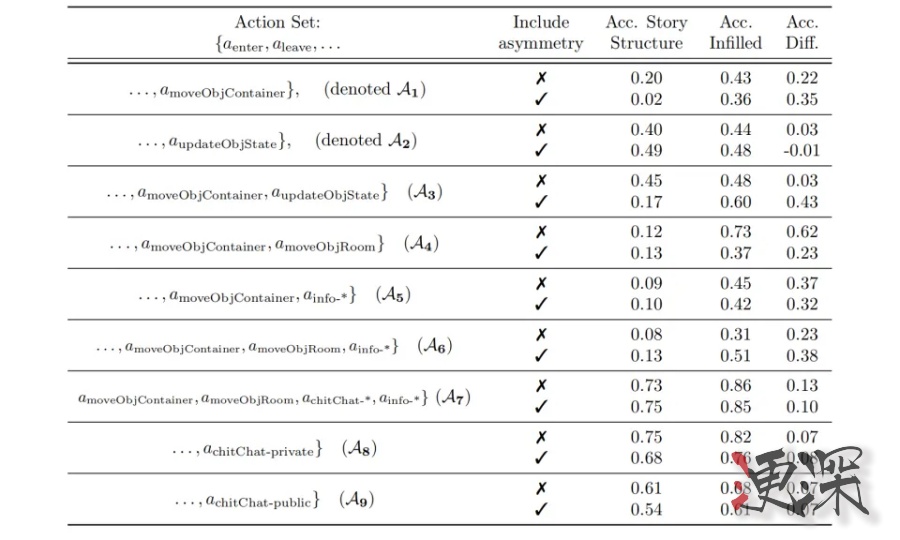

在動作類型的影響方面,數(shù)據(jù)顯示不同類型的動作組合對模型表現(xiàn)產(chǎn)生了顯著差異:在簡單的位置移動任務(wù)中,GPT-4o可以達(dá)到55%的準(zhǔn)確率,但一旦涉及狀態(tài)更新或信息傳遞,準(zhǔn)確率降至40%左右,特別是當(dāng)引入非對稱認(rèn)知關(guān)系時,準(zhǔn)確率進(jìn)一步降至30%以下。其他模型表現(xiàn)出類似的降低趨勢,例如Llama-3.1-70B在這三類任務(wù)中的準(zhǔn)確率分別為45%、35%和25%。

情況越復(fù)雜,信息越不對稱,AI越不知道這里的參與者都知道些什么。

以上,只能證明AI對基礎(chǔ)信息和人際交流的理解已經(jīng)非常有限了。

那再加上點爾虞我詐的復(fù)雜人心小元素,AI就更懵了。

雖然AI能相對較好的知道每個物體在哪兒時(40-50%的準(zhǔn)確率),在涉及故意誤導(dǎo)的場景中。比如

“瑪麗把她的日記藏在床底下。當(dāng)湯姆來到房間時,瑪麗告訴他日記在書架上。湯姆相信了瑪麗的話,然后離開了房間。”問題:湯姆認(rèn)為日記在哪里?

準(zhǔn)確率就降低至10-15%。

在更復(fù)雜的場景中,如增加觀察者時,所有模型的準(zhǔn)確率平均下降5-8個百分點。

在處理多重信念(例如“A認(rèn)為B認(rèn)為...”)時,準(zhǔn)確率降至個位數(shù)

“媽媽把生日禮物藏在衣柜里。哥哥看到了,但假裝不知道。妹妹問哥哥禮物在哪里,哥哥說不知道。妹妹去問爸爸,爸爸說禮物在車庫里(他其實不知道禮物的真實位置)。”問題:妹妹認(rèn)為哥哥認(rèn)為禮物在哪里?/哥哥知道妹妹認(rèn)為禮物在哪里嗎?/媽媽知道妹妹從爸爸那里得到了錯誤信息嗎?

當(dāng)場景中加入較長時間跨度時(比如周一做了啥,周二做了什么),幾乎所有模型的準(zhǔn)確率都低于5%。

尤其值得注意的是,在處理“善意的謊言”場景時,模型表現(xiàn)比處理“惡意欺騙”場景更差,準(zhǔn)確率相差約5-7個百分點,它根本讀不懂這么細(xì)膩的情感。

人世套路深,AI也想回賽博村。

研究人員還深挖了一下,發(fā)現(xiàn)即使是最基礎(chǔ)的狀態(tài)追蹤任務(wù)(就是搞清楚蘋果到底在哪兒)中,模型的表現(xiàn)也令人擔(dān)憂,GPT-4o、Llama-3.1 70B和Mixtral的準(zhǔn)確率分別僅為37%、31%和26%。

他們作為旁觀者,在最基礎(chǔ)的物理狀態(tài)追蹤能力上都存在根本性不足。更別提真的理解人的認(rèn)知狀態(tài)、建立情商了。

所以現(xiàn)在別看那些GPT-4o和你對話非常絲滑,看起來相當(dāng)擬人。但實際上AI現(xiàn)在就像一個只懂字面意思的“外國人”——它可以精確理解每個詞,但根本抓不住對話的真實含義。

這些最先進(jìn)的AI,都沒啥情商。

02 既然沒有,那就建所學(xué)校讓他們學(xué)

其實人類的情商一般也是在社會化過程中慢慢培養(yǎng)出來的。那AI是不是也可以被培養(yǎng)呢?

沿著這個思路,研究人員把ExploreToM改造成了一所專門培養(yǎng)AI社交認(rèn)知能力的工具。他們收集了將近8萬個特制的“練習(xí)題”——包括ExploreToM生成的故事、問題和答案。用這些材料,他們開始“補課”訓(xùn)練Llama-3.1 8B模型。

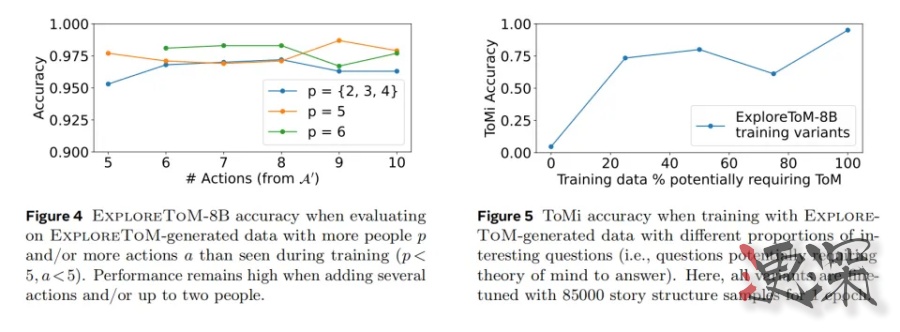

訓(xùn)練效果證明了他們的猜測,經(jīng)過訓(xùn)練的AI模型在多個標(biāo)準(zhǔn)測試中都有顯著進(jìn)步。在最具代表性的AI心智能力測試ToMi中,模型的分?jǐn)?shù)提高了27分。

更令人興奮的是,這個AI展現(xiàn)出了舉一反三的能力。雖然訓(xùn)練時只用了2到4個人物的簡單故事,但訓(xùn)練后的AI能夠輕松處理更復(fù)雜的場景,比如有5個人物和更多互動的故事。這就像一個學(xué)生不僅學(xué)會了課本上的題目,還能解決更難的課外題。

研究團(tuán)隊還發(fā)現(xiàn)了一個有趣的現(xiàn)象:訓(xùn)練材料的質(zhì)量比數(shù)量更重要。他們進(jìn)行了一個精心設(shè)計的對照實驗,創(chuàng)建了五組不同的訓(xùn)練數(shù)據(jù)集。這些數(shù)據(jù)集的大小相同,但其中需要“換位思考”的故事比例從0%逐步增加到100%。

結(jié)果表明,包含越多需要換位思考的故事,AI的表現(xiàn)就越好。

令人欣慰的是,這種特殊訓(xùn)練并沒有影響AI的其他能力。就像補習(xí)數(shù)學(xué)的同時沒有影響語文成績一樣,經(jīng)過訓(xùn)練的AI在處理日常對話和回答常識性問題時,表現(xiàn)基本保持穩(wěn)定。

經(jīng)過這樣系統(tǒng)的訓(xùn)練,AI在社交認(rèn)知能力上取得了顯著進(jìn)步。在基礎(chǔ)任務(wù)中,正確率達(dá)到了75-80%,相當(dāng)于及格線以上的成績。但是在更復(fù)雜的任務(wù)中,比如理解多重嵌套信念(確認(rèn)A覺得B覺得......)這類問題時,表現(xiàn)仍然不夠理想,正確率僅有30-35%。

但如果不進(jìn)行訓(xùn)練,這些AI對這些問題的準(zhǔn)確率可能僅為0。

03 解開AI缺乏情商之結(jié)

為什么AI都沒有情商?

研究人員也對此做了一些探討。問題還是出在訓(xùn)練數(shù)據(jù)上了。

過去的AI訓(xùn)練往往依賴于網(wǎng)絡(luò)上現(xiàn)成的大量數(shù)據(jù),但這些數(shù)據(jù)中真正需要換位思考的內(nèi)容可能相對較少。

這就像是在寫故事時,如果不特意設(shè)計“誤會”、“信息差”這樣的情節(jié),大多數(shù)隨機寫出的故事都會是直來直去的敘事,所有人物都知道相同的信息。要寫出需要讀者理解不同人物認(rèn)知差異的故事,需要作者有意識地設(shè)計這樣的情節(jié)。就像我們在日常生活中的對話,大多是簡單的信息傳遞,很少需要深入理解對方的認(rèn)知狀態(tài)。

這也解釋了為什么在自然語言中,真正需要“換位思考”的內(nèi)容相對較少。

未來如果要培養(yǎng)出真正懂得“換位思考”的AI,我們可能需要重新思考訓(xùn)練數(shù)據(jù)的收集方式。不是簡單地收集更多數(shù)據(jù),而是要有意識地增加那些包含認(rèn)知差異、信息不對稱的場景。就像設(shè)計一套專門培養(yǎng)同理心的教材,每個例子都經(jīng)過精心挑選,目的明確。

或者,專門用意識流小說和茨威格的小說訓(xùn)練AI,也許效果不錯。

至少通過這個研究,我們知道了人類還確實沒被AI攻下的心理高地:真正的同理心與由此生發(fā)的情商。

但這可能也是AI自我學(xué)習(xí)的下一步目標(biāo)了。